Durant notre sprint n° 11 nous avons fait une évaluation sur trois outils d’indexation. Nous vous présentons la procédure de cette évaluation et ses résultats.

Présentation des outils :

- Grobid Keyterm : C’est un outil d’indexation développé par Patrice Lopez. Cet outil utilise une approche supervisée pour indexer les documents. Il y a une étape de désambiguïsation avec Wikipédia pour les termes. Il prend en entrée les fichier en PDF. Le format de sortie est en JSON. Grobid-keyterm est basée sur le prototype HUMB de SemEval 2010 (https://hal.inria.fr/inria-00493437), avec quelques modifications pour le rendre plus portable sur différents domaines (la tâche de SemEval étant basée sur des articles uniquement en informatique) et améliorer son runtime (moins de features).

- rd-teeft : Outil d’indexation developpé par l’équipe ISTEX-R&D en NODE.JS. En entrée il prend un fichier TXT et donne en sortie un standoff en format TEI avec les termes, leur fréquence et leur spécificité.

Les étapes d’indexation dans rd-teeft :

– Tokenization du fulltext de l’objet docmentaire

– Etiquetage des tokens

– Lemmatization des tokens étiquetés

– Calcul des fréquences et des spécificités

– Pondération des spécificités (avec un dictionnaire mot <=> coeff de pondération)

Voici un exemple de Standoff généré par la module rd-teeft:

0A1C09E7BDB1B04AE1D6ABDE2EE2EA42D866428B_schizophrenia

L’élément standOff de ce document est distribué sous licence Creative Commons 4.0 non transposée (CC BY 4.0)

Ce standOff a été créé dans le cadre du projet ISTEX – Initiative d’Excellence en Information Scientifique et Technique

prepulse

77

1

1.0.0

- TopikRank : https://github.com/adrien-bougouin/KeyBench/blob/topicrank_topiccorank_stable/README.md Un outil d’indexation développé en Python par Adrien Bougouin. En entrée il prend un fichier TXT et donne en sortie les termes et leurs spécificité en format TXT. Il traite les langues français et anglais.

Procédure d’évaluation :

- Construction d’un corpus de 20 documents en anglais de la base de données ISTEX avec des thématiques variées (climat, psychologie, mathématiques, etc,…)

- Indexation manuelle de ces 20 documents afin d’avoir une référence pour l’évaluation des outils d’indexation. Nous n’avons pas de limite de nombre de mots choisis pour cette étape.

- Passage des 20 documents sur les 3 outils: Grobid keyterm, Teeft, TopikRank ; ne sont pris en compte que les 20 premiers mots-clés sortis par outil pour chaque document.

- Révision des indexations manuelles : ajout des mots-clés pertinents trouvés par les outils d’indexation automatique.

- Comparaison des résultats des outils avec les indexations manuelles et calcul de Rappel, Précision et F-score pour chaque outil.

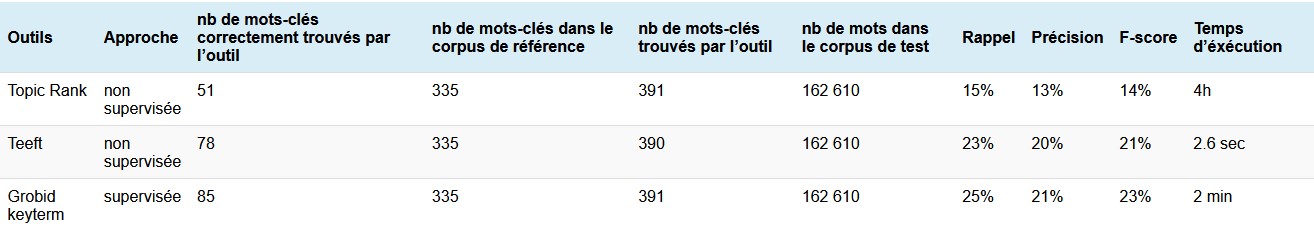

Résultats d’évaluation :

Analyse des résultats:

Tout en étant conscient que les indexations manuelles sont subjectives et ça peut varier d’une personne à l’autre, nous avons fait cette procédure d’évaluation.

Nous constatons que les outils Teeft et Grobid Keyterm avec les F-score de 21% et 23% sont plus performants que TopikRank sur les fulltext de notre corpus. TopikRank est utilisé pour l’indexation des titres et des résumés, donc le temps d’exécution sur un corpus fulltext était trop long. Le temps d’exécution de Teeft est plus court par rapport à Grobid Keyterm.

Selon nos lectures des articles sur l’indexation, les outils plus performants dans ce domaine n’ont pas dépassé le F-score de 28% sur fultext.

Référence

http://www.hlt.utdallas.edu/~saidul/acl14.pdf

Besoin d'aide ?

Consultez notre Faq, la documentation Istex ou nos tutoriels

N’hésitez pas à nous contacter si besoin, nous reviendrons rapidement vers vous !